Algoritmi razzisti14 min read

«Se inserisci spazzatura, uscirà spazzatura»: è il modo di dire tanto sintetico quanto efficace con cui gli scienziati informatici illustrano che cosa possa andare storto quando si addestra un’intelligenza artificiale. Il significato di questa frase, per chiunque abbia un’infarinatura del funzionamento degli algoritmi di deep learning (che nella nostra epoca sono quasi un sinonimo di intelligenza artificiale), è molto semplice: la qualità dei risultati ottenuti da un algoritmo dipende in larghissima parte dalla bontà dei dati utilizzati per addestrarlo. Sono i dati, infatti, il cibo di cui queste macchine si nutrono: il fondamento su cui le AI costruiscono la loro capacità di trarre conclusioni o fare previsioni.

Di conseguenza, se i dati non sono di buona qualità ne risentirà anche il lavoro compiuto dall’algoritmo. Un esempio banale potrebbe riguardare un sistema che ha il compito di stimare il prezzo delle case. Se nei dati utilizzati per l’addestramento non sono riportate le condizioni dell’abitazione (se è nuova di zecca, in buono stato o invece da ristrutturare), le stime elaborate si baseranno soltanto sui metri quadrati e sulla zona in cui la casa di trova, fornendo valutazioni inutilizzabili.

Le conseguenze possono essere però molto più gravi nel caso in cui i dati forniti non sono soltanto di scarsa qualità, ma addirittura viziati da pregiudizi umani che vengono quindi incorporati dalla macchina. In questi casi, i risultati ottenuti possono essere tanto assurdi quanto, potenzialmente, pericolosi. L’esempio più celebre di questo problema – chiamato pregiudizio algoritmico e che secondo il capo del dipartimento dell’intelligenza artificiale di Google, John Giannandrea, è il più importante ostacolo da superare in questo settore – riguarda il chatbot Tay.

Un bot nazista?

Tay è un software progettato da Microsoft che aveva il compito di imparare a comunicare attraverso le sue interazioni (che rappresentano quindi i dati alla base dell’addestramento) con gli utenti in carne e ossa del social network. Col senno di poi, era prevedibile che sarebbe successo ciò che infatti è prontamente accaduto: appena venuti a conoscenza del nuovo ospite di Twitter, si sono scatenati i troll, che hanno iniziato a comunicare con Tay dandole in pasto una miriade di opinioni razziste, omofobe, antisemite, sessiste e tutto il peggio che l’umanità è in grado di offrire. Risultato? Nel giro di 24 ore, Tay è diventata la prima intelligenza artificiale nazista della storia. Prima di venir chiusa in fretta e furia da Microsoft, è riuscita tra le altre cose a twittare il suo supporto a Hitler, a esclamare che vorrebbe veder bruciare le femministe all’inferno e altre oscenità del genere..

Quello di Tay è un caso particolare, visto non c’era alcun modo di controllare i dati che le venivano somministrati tramite le interazioni con gli altri utenti. Problemi molto simili, però, si sono verificati anche quando sono stati proprio gli scienziati a istruire l’algoritmo. Nell’ottobre del 2017, per esempio, si è scoperto che il software di Google chiamato Cloud Natural Language API – che ha il compito di “rivelare la struttura e il significato dei testi” – giudicava negativamente alcune affermazioni relative alla religiosità e alla sessualità, come «sono ebreo» o «sono gay».

Il giudizio era ovviamente in forma matematica: l’esperimento condotto da un ricercatore informatico ha infatti mostrato come l’algoritmo desse un valore positivo di +0,1 alla frase «sono un cristiano», e un valore invece negativo (-0,2) alla frase «sono ebreo». Allo stesso modo, dichiarare di «essere un ragazzo etero francese» portava l’algoritmo a dare un valore di +0,2, mentre sostenere di «essere una donna nera gay» faceva scendere il giudizio fino a -0,3.

Com’è possibile? Il problema è che algoritmi di questo tipo vengono allenati utilizzando i testi reperiti nei libri o negli articoli (che rappresentano un materiale dal quale è molto facile estrarre i dati). Di conseguenza, spesso e volentieri non fanno che riproporre i pregiudizi contenuti nel materiale umano che viene usato per il loro addestramento. La ricercatrice Amanda Levendowski, della New York University, ha individuato una delle ragioni per cui spesso i testi analizzati dalle intelligenze artificiali sono viziati da pregiudizi: è il diritto d’autore, che costringe i ricercatori a utilizzare vecchi testi di dominio pubblico.

«La maggior parte delle opere oggi di dominio pubblico è stata pubblicata prima degli anni ’20», ha spiegato Levendowski a Motherboard USA. «Un database che faccia affidamento solo su questi lavori non potrà che riflettere i pregiudizi del tempo; e lo stesso farà il sistema di intelligenza artificiale allenato usando questi dati». Per banalizzare, un algoritmo che apprende informazioni sul mondo leggendo Il grande Gatsby, opera del 1925, non potrà che dare per scontato che solo gli uomini bianchi abbiano ricchezza e potere e che invece i neri possano occuparsi solo della servitù.

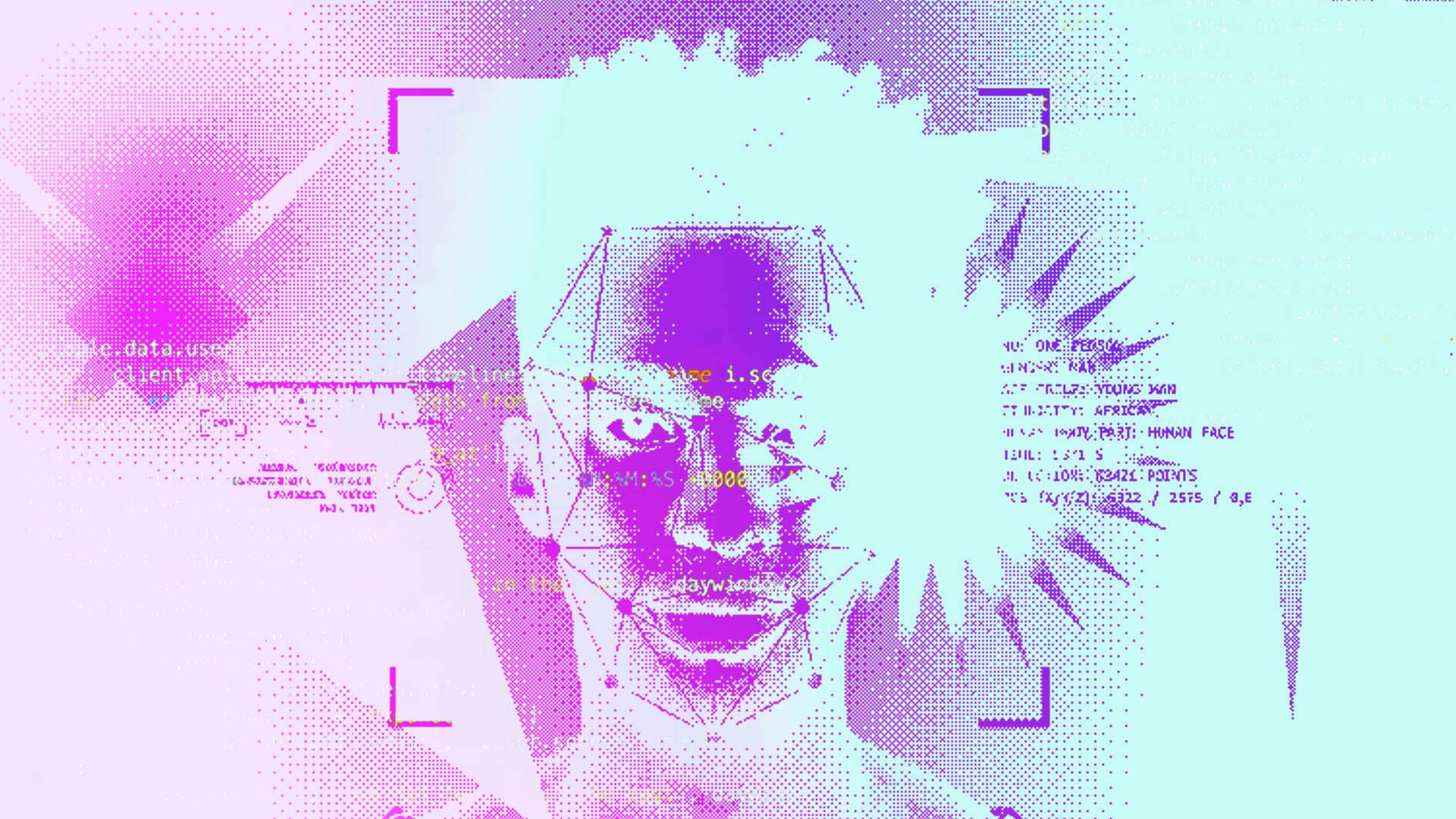

I rischi del riconoscimento facciale

Per ragioni molto simili, non c’è da dare credito nemmeno alle intelligenze artificiali che promettono di riconoscere un criminale (o addirittura una persona gay!) analizzandone il volto. Prima di tutto, perché le teorie di Lombroso sono state confutate da tempo e non saranno certo le intelligenze artificiali a riportarle in vita; secondariamente perché, come abbiamo visto, le previsioni di questi algoritmi potrebbero benissimo replicare pregiudizi tutti umani sul fatto che, per esempio, i migranti abbiano una maggiore propensione al crimine (cosa ovviamente falsa, soprattutto se messa in termini “biologici”).

Se la popolazione carceraria negli Stati Uniti è costituita in maniera sproporzionata da uomini e donne neri è per tutta una serie di complicatissime questione sociali, economiche e politiche. Un algoritmo, invece, non potrebbe che limitarsi a valutare che i neri sono sovrarappresentati in carcere e, di conseguenza, aumentare la percentuale di probabilità che una singola persona nera sia un criminale.

Per fortuna, nessuna istituzione sta utilizzando questi “algoritmi lombrosiani”. Lo stesso invece non si può dire per gli algoritmi che si occupano di riconoscimento facciale e che promettono di identificare la persona presente in una foto confrontandola con le immagini contenute nel suo database (esattamente ciò che faceva Facebook quando riconosceva autonomamente le persone presenti nelle foto di gruppo pubblicate sul social network).

Uno dei casi più recenti ha come protagonista Amazon Rekognition, il software per il riconoscimento facciale progettato dal colosso fondato da Jeff Bezos e venduto alle forze dell’ordine di tutto il mondo. Nel luglio del 2018, la ACLU (American Civil Liberties Union) ha testato il programma e pubblicato gli esiti dell’esperimento. Utilizzando un database di 25mila foto segnaletiche accessibili al pubblico, e confrontandole con le foto dei 535 parlamentari statunitensi, Rekognition ha individuato 28 politici eletti alla Camera e al Senato. Vale a dire che ha confuso 28 parlamentari con i criminali le cui foto segnaletiche sono archiviate nei database della polizia.

Gli algoritmi non sono razzisti, omofobi o misogini: sono soltanto lo specchio della società che li ha creati.

Fin qui, ci troviamo davanti a un ulteriore esempio della (pericolosa) inaccuratezza di questi sistemi. Ma c’è di più: nel 39% dei casi, i parlamentari confusi per criminali erano uomini e donne di colore; che però rappresentano solo il 20% degli esponenti del Congresso. In poche parole, una persona di colore ha circa il doppio della possibilità di essere confuso per un criminale rispetto a un bianco; perpetuando in questo senso gli stessi pregiudizi di cui è vittima una parte consistente della società occidentale.

Questo avviene perché gli algoritmi di face recognition sono addestrati utilizzando immagini d’archivio – per esempio gli stock delle agenzie fotografiche – composte in larghissima parte da uomini bianchi (anche se la situazione sta gradualmente cambiando). Risultato? Inevitabilmente, questi strumenti diventano molto accurati quando si tratta di riconoscere uomini bianchi, meno accurati quando si tratta di uomini di etnie diverse e per niente accurati quando le persone da riconoscere sono, per esempio, donne nere. Così, diventa molto più facile fare confusione e confondere una persona per un’altra.

Ma quelli di cui abbiano parlato finora sono solo i casi più evidenti e più noti. Nascosti dietro una patina di oggettività matematica (dal momento che le intelligenze artificiali, di loro, si limitano a eseguire complicatissimi calcoli statistici), i pregiudizi degli algoritmi sono spesso molto difficili da individuare. In alcuni casi, insomma, è complicato anche solo rendersi conto che qualcosa, nelle valutazioni dei sistemi che utilizzano il deep learning, non sta andando per il verso giusto (un’incognita nota come Black Box).

Come si fa ad accorgersi se un algoritmo utilizzato per decidere quali carcerati abbiano diritto a uscire prima di galera – o anche chi può accedere a un mutuo oppure quale sia il candidato migliore da assumere per un determinato posto di lavoro – sta prendendo decisioni viziate da una qualche forma di pregiudizio? Rendersi conto di tutto ciò è in alcuni casi impossibile, amplificando ulteriormente i rischi connessi alla diffusione di sistemi di intelligenza artificiale a cui affidiamo, ormai, anche scelte molto delicate.

Qualcosa si muove

Rischi resi ancora più concreti dal fatto che, per lungo tempo, la politica non ha saputo affrontare il problema, principalmente a causa di una cronica mancanza di competenze in merito. A fare eccezione è la deputata democratica Alexandria Ocasio-Cortez, che per prima, e in varie occasioni, ha evidenziato i pericoli che si nascondono dietro l’utilizzo di questi sistemi, mostrando una conoscenza non comune tra i politici di oggi: «Gli algoritmi sono comunque fatti da esseri umani, e questi algoritmi sono comunque collegati a delle basilari supposizioni umane», ha affermato l’esponente democratica. «Sono semplicemente automatizzati. E delle supposizioni automatizzate, se non sistemi i problemi, portano a pregiudizi automatizzati».

Parole che rievocano quanto spiegato durante un TED Talk dalla ricercatrice del MIT Joy Buolamwini: «Si dà per scontato che le macchine siano neutrali e c’è addirittura la speranza che la tecnologia che creiamo abbia meno pregiudizi di noi. Ma non abbiamo equipaggiato questi sistemi con gli strumenti necessari a sconfiggere i nostri bias».

Ciononostante, i governi e le forze dell’ordine di tutto il mondo si stanno dotando senza troppo pensarci – anche in Italia – di sistemi di riconoscimento facciale negli aeroporti, alle frontiere, negli stadi, direttamente sulle strade (per non parlare degli algoritmi di polizia predittiva, che sono vittima degli stessi problemi ma con implicazioni, se possibile, ancora più profonde). Com’è stata possibile una tale diffusione, considerando la quantità di problemi riscontrata?

La risposta a questa domanda, banalmente, la possiamo trovare nel modo in cui un reporter del foglio conservatore statunitense Daily Wire ha risposto proprio al primo politico di spicco che ha sollevato la questione: «La socialista Alexandria Ocasio-Cortez afferma che gli algoritmi, che sono guidati dalla matematica, sono razzisti», ha infatti scritto su Twitter Ryan Saavedra. Come dire, ma di che cosa starà mai parlando?

La scarsa consapevolezza del funzionamento di questi strumenti – considerati neutri e oggettivi in quanto basati sulla matematica (o, più precisamente, sulla statistica) – è ciò che ha permesso una loro diffusione incontrollata, senza che venissero prese le necessarie contromisure e senza attendere che si raggiungesse un livello di accuratezza tale da renderle veramente affidabili.

Qualcosa, però, si sta finalmente muovendo. È infatti proprio per la ragioni esposte finora che, per esempio, una città come San Francisco è diventata la prima a vietare l’utilizzo del riconoscimento facciale. A farle prendere questa cruciale decisione, però, non è stato solo il rischio provocato dal pregiudizio algoritmico. «Le preoccupazioni che hanno motivato la messa al bando decisa a San Francisco non hanno radice solo nella potenziale inaccuratezza delle tecnologie di riconoscimento facciale. Questa ordinanza è stata messa a punto (…) anche perché è stato più volte dimostrato che una sorveglianza troppo ampia ha un impatto deleterio sulla società, a partire dalle comunità più svantaggiate», ha scritto sul Guardian il docente di Legge Veena Dubal.

Eliminare il pregiudizio

Come ha sintetizzato un avvocato della ACLU, il riconoscimento facciale è «una minaccia per la privacy quando funziona e una minaccia razzista quando non funziona». Ma è possibile risolvere almeno il secondo dei due problemi? Prima di tutto, è urgente diversificare e rendere più inclusivo l’ambiente in cui questi algoritmi vengono creati. «È necessario che le persone che programmano questi sistemi provengano da background molto diversi tra loro. Se gli algoritmi vengono addestrati sempre dallo stesso tipo di persone, inevitabilmente verranno prodotte intelligenze artificiali vittime di stereotipi e pregiudizi», ha spiegato Ann Johnson, vicepresidente di Microsoft, in occasione del Digital Summit 2019 di Dublino. «È quindi fondamentale che a creare questi sistemi siano persone che vedono il mondo con lenti diverse».

Non si tratta solo di rendere più inclusiva una realtà, come quella della Silicon Valley, che sconta gravi limiti in termini di diversità: «Abbiamo bisogno di persone provenienti da zone diverse del mondo, che abbiano compiuto studi diversi e siano cresciute in contesti differenti», precisa la vicepresidente di Microsoft. Solo in questo modo si possono ridurre al minimo i pregiudizi (consci e inconsci) che ogni singola cultura porta con sé.

Ma non è tutto: «Dobbiamo essere anche in grado di sfidare i nostri confini», conclude Ann Johnson. «Per esempio, dovremmo eliminare la binarietà di genere da alcuni dei questionari con cui raccogliamo i dati; altrimenti chi non si riconosce nella dicotomia uomo/donna verrà inevitabilmente discriminato». In poche parole, gli algoritmi non sono razzisti, omofobi o misogini: sono soltanto lo specchio della società che li ha creati. Ed è forse anche per questo che recentemente IBM, Amazon e anche proprio Microsoft hanno deciso di ritirare i loro software per il riconoscimento facciale (ma i veri player di questo settore sono ancora attivi). Per eliminare i pregiudizi algoritmici bisogna prima eliminarli dalla società. E il cammino per raggiungere questo obiettivo è appena iniziato.