La resistibile invasione dei deepfake17 min read

La resistibile invasione dei deepfake

Porno, politica e truffe finanziarie. Ma se il problema diventasse il nostro disinteresse nei confronti della verità?

È stato l’Ocean’s Eleven della cybercriminalità: forse il furto più complesso mai avvenuto nel mondo digitale. Il periodo non è stato precisato, ma probabilmente ci troviamo sul finire del 2023. Il luogo è invece noto: siamo a Hong Kong, all’interno di una multinazionale della finanza. Un dipendente riceve un’email contenente il link per collegarsi a una videoconferenza su Zoom. Il mittente è uno dei massimi dirigenti della società, che nella email anticipa di dover discutere della necessità di eseguire rapidamente una transazione segreta.

Il dipendente, il cui nome non è stato diffuso, non è convinto della genuinità dell’email, ma decide comunque di partecipare alla videoconferenza. Una volta entrato, ogni suo dubbio si dissipa: assieme a lui sono presenti colleghi di cui riconosce il volto e la voce, e il dirigente da cui è partita la mail. Persuaso che tutto ciò che sta avvenendo su Zoom sia vero, il dipendente accetta di inviare in segretezza un bonifico da 25,6 milioni di dollari verso un ignoto destinatario.

Peccato che, stando a quanto riporta la polizia di Hong Kong, nulla di tutto ciò fosse vero. Il dipendente sarebbe infatti stato attirato in una complicatissima trappola: la videoconferenza a cui ha partecipato sarebbe stata popolata esclusivamente da deepfake, imitazioni digitali di persone realmente esistenti (voce compresa) create tramite sistemi di intelligenza artificiale.

Deepfake politici e pornografici

Ci sono alcuni aspetti da chiarire in questa vicenda – per esempio: il dipendente ha interagito con gli altri “presenti”? E se sì, significa che è possibile manipolare un deepfake in tempo reale? – ma se le indagini della polizia confermassero la ricostruzione, quanto avvenuto a Hong Kong rappresenterebbe senza ombra di dubbio la più clamorosa truffa messa a segno usando la tecnologia che permette di ricreare le fattezze di qualunque persona, riproducendo anche la sua voce e facendogli quindi dire ciò che si vuole.

Altri casi di deepfake sono meno elaborati ma altrettanto inquietanti, soprattutto per le implicazioni politiche e sociali. Per esempio, il 28 settembre 2023, solo due giorni prima delle elezioni in Slovacchia, era circolata massicciamente una registrazione audio pubblicata su Facebook. Nella registrazione si sentono le voci del candidato europeista Michal Šimečka e della giornalista Monika Tódová mentre discutono di come truccare le elezioni comprando voti dalla minoranza rom presente nel paese. La registrazione – come denunciato immediatamente dai due protagonisti e come confermato dall’agenzia di stampa AFP – è però falsa: un deepfake creato usando uno dei tantissimi software reperibili in rete che permettono con pochi click di riprodurre la voce di chiunque.

Qualcosa di simile è capitato sul finire dello scorso gennaio anche a Joe Biden, la cui voce è stata ricreata in una serie di chiamate automatiche con cui si chiedeva agli elettori democratici del New Hampshire (dove si sono tenute le primarie democratiche) di non andare a votare per il presidente in carica e di “risparmiare il loro voto per novembre”. E poi ci sono i casi avvenuti in Bangladesh, dove i deepfake vengono usati dal partito al potere per screditare l’opposizione; in Pakistan, dove l’ex primo ministro Imran Khan, incarcerato l’anno scorso, riesce comunque a diffondere discorsi sui social grazie all’intelligenza artificiale e altri ancora.

Le prime tracce di questa tecnologia risalgono al 2017, quando su Reddit l’utente “deepfakes” pubblicò una serie di grossolani video porno.

Le prime tracce di questa tecnologia risalgono al 2017, quando su Reddit l’utente “deepfakes” pubblicò una serie di grossolani video porno, manomessi per far sembrare che l’attrice protagonista fosse la star di Hollywood Gal Gadot. Da allora, la tecnologia ha fatto passi da gigante: se fino a qualche anno fa erano necessarie settimane di lavoro, ingenti risorse e personale specializzato per creare deepfake credibili, oggi chiunque può cimentarsi nell’opera e ottenere buoni risultati in pochi minuti.

Inevitabilmente, tutto ciò ha sollevato enorme preoccupazione: il timore non è soltanto che queste fake news potenziate tramite l’integrazione di video e audio compromettano le imminenti elezioni statunitensi ed europee, ma che addirittura portino la nostra società sull’orlo di una “apocalisse epistemica” e al “collasso della verità”.

Eppure, fino a questo momento, i tantissimi allarmi che ormai da parecchi anni vengono lanciati si sono rivelati infondati. Lasciando da parte la vicenda di Hong Kong e restando nell’ambito della politica, lo stesso candidato slovacco Šimečka ha affermato di non ritenere che il deepfake di cui è stato protagonista abbia contribuito alla sua sconfitta; mentre le chiamate con cui un falso Biden diceva agli elettori di stare a casa non hanno impedito al vero Biden di ottenere una facilissima vittoria (come sempre avviene con le primarie a cui partecipa il presidente in carica, che non ha veri concorrenti).

“È ormai da quattro anni che i deepfake sono considerati il prossimo grande problema che si verificherà nei successivi sei mesi”, ha spiegato all’Atlantic Joshua Tucker, del Center for Social Media and Politics dell’Università di New York. “Fa parte di una tendenza generale dei media osservata negli ultimi anni, in cui si esagerano le minacce tese a ingannare gli elettori”.

Brevissima storia dell’immagine contraffatta

D’altra parte, i deepfake per molti versi non sono una novità. Anzi, esistono fin da quando l’essere umano inventò il primo mezzo di comunicazione che, almeno apparentemente, non può mentire: la macchina fotografica. Nonostante all’epoca venisse considerata, come segnala il New Yorker, uno “specchio dotato di memoria”, già nel Diciannovesimo secolo i fotografi erano soliti ritoccare e modificare i negativi della pellicola, trattandoli come se fossero delle bozze su cui intervenire liberamente.

Nonostante all’epoca venisse considerata, come segnala il New Yorker, uno “specchio dotato di memoria”, già nel Diciannovesimo secolo i fotografi erano soliti ritoccare e modificare i negativi della pellicola.

La distanza tra l’oggettività percepita della macchina fotografica e il lavoro che invece eseguivano i fotografi produsse risultati curiosi. È noto il caso di Arthur Conan Doyle, che divenne ossessionato da una sequenza di fotografie che mostravano alcune ragazze in compagnia di fate. Non si trattava di falsi sofisticati, scrive sempre il New Yorker: le fate erano state semplicemente disegnate, ritagliate e disposte davanti alla macchina fotografica usando degli spilli. Eppure, Conan Doyle – padre letterario di Sherlock Holmes, ma nella vita privata affascinato dallo spiritismo – fu talmente colpito da queste immagini da convincersi che fossero una dimostrazione dell’esistenza delle fate.

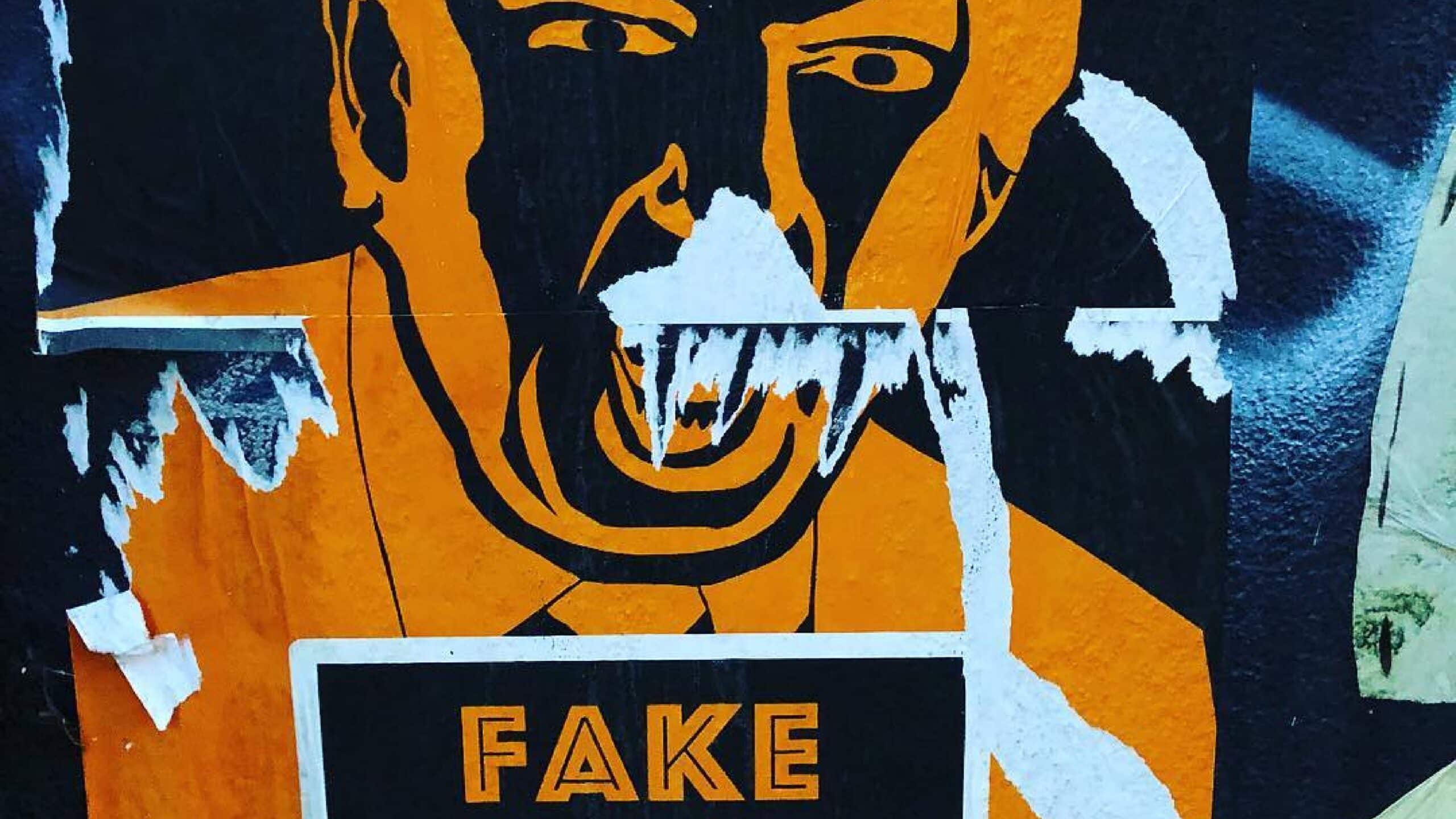

Risale invece al 1950 un episodio di disinformazione politica a opera del senatore Joseph McCarthy (quello del maccartismo), che in un weekend pre-elettorale distribuì centinaia di immagini contraffatte che mostravano il suo avversario Millard Tydings mentre parlava con il noto comunista Earl Browder. Anche in questo caso, non si trattava di un falso sofisticato e non è dato sapere quante persone ci siano cascate, ma l’episodio dimostra come certi trucchi siano sempre stati utilizzati, approfittando dell’opinione comune che considerava oggettivi degli strumenti che potevano invece essere soggetti a manipolazione.

Allarmismi più simili a quelli odierni si verificarono invece a partire dagli anni Novanta con la nascita di Photoshop, il più noto software di elaborazione fotografica. Il timore di essere inondati da immagini false ma non riconoscibili come tali contribuì alla diffusione della “media forensics” (la scientifica dei media) e allo sviluppo, grazie anche agli investimenti dell’esercito statunitense, dei primi strumenti di identificazione di immagini false. Eppure, a 35 anni di distanza dalla nascita, Photoshop non è mai stato considerato un efficace strumento di disinformazione.

E quindi: la manomissione di immagini è vecchia quanto la fotografia, alcuni celebri casi di pionieristici deepfake risalgono addirittura ai primi del Novecento e i progressi tecnologici avrebbero permesso già da decenni di diffondere immagini fasulle a scopi di propaganda. Eppure gli scenari più catastrofisti non si sono mai realizzati e i casi di efficace disinformazione condotta tramite immagini manomesse sono estremamente rari. Com’è possibile?

Spesso si sottolinea come all’essere umano non sia sufficiente vedere un’immagine per crederci: il nostro scetticismo, il buon senso e la verifica sociale (quando cioè ci confrontiamo con altre persone di fronte a qualcosa che ci sembra troppo strano per essere vero) ci proteggono dagli inganni.

Anche in quest’epoca di intelligenza artificiale generativa, gli esseri umani si sono rivelati particolarmente bravi a scovare i fake. Secondo un recente studio del Media Lab dell’MIT di Boston, il più noto strumento di identificazione dei deepfake aveva assegnato a una foto finta di Vladimir Putin solo l’8% di possibilità di essere, appunto, finta. Tra i partecipanti allo studio si arrivava invece al 70%. Una discrepanza spiegata dai ricercatori con i tanti strumenti che le persone, ma non le macchine, hanno per valutare la genuinità di un’immagine al di là della sua verosimiglianza tecnica.

Travolti dalla diffidenza

Per questa ragione, molti segnalano che la vera minaccia non venga da deepfake spesso troppo strani per essere ritenuti credibili (Putin che bacia la mano a Xi Jinping e simili), ma dai cosiddetti “cheap fake”: immagini di conflitti precedenti – o tratti da film – pubblicate come se fossero relative a quelli in corso, discorsi di presidenti esteri a cui vengono aggiunti sottotitoli che non c’entrano nulla con quanto stanno realmente dicendo, video in cui i politici sembrano biascicare da ubriachi semplicemente perché la riproduzione del filmato è rallentata (è quanto notoriamente avvenuto a Nancy Pelosi).

Chi ha bisogno di deepfake tecnologicamente avanzati quando bastano piccole modifiche a un video o un’immagine decontestualizzata per scatenare una tempesta disinformativa? In realtà, le cose non sono così semplici. Non è l’efficacia, la verosimiglianza o l’elevato livello tecnico che ci portano a credere ai deepfake. La cosa che più conta – secondo i tanti studi che hanno indagato il fenomeno – è se vogliamo credere o meno a ciò che stiamo vedendo. È il cosiddetto “pregiudizio di conferma”, che ci porta a ritenere vero – o almeno credibile – ciò che conferma le nostre opinioni, i nostri sospetti, le nostre tendenze.

È il cosiddetto “pregiudizio di conferma”, che ci porta a ritenere vero – o almeno credibile – ciò che conferma le nostre opinioni, i nostri sospetti, le nostre tendenze.

Il cheap fake con protagonista Nancy Pelosi “ubriaca” era molto più credibile agli occhi di un elettore repubblicano che di uno democratico; mentre l’immagine fasulla dei tifosi che allo stadio di Madrid espongono una gigantesca bandiera della Palestina è stata condivisa migliaia di volte da sostenitori della causa palestinese, nonostante fosse chiaramente e grossolanamente generata da un sistema di intelligenza artificiale.

Come segnala il Centre for Research on Extremism and Security Threats, le persone spesso condividono contenuti disinformativi anche quando sanno che si tratta di fake news. L’importante, in questi casi, non è che la notizia sia vera o falsa oppure che l’immagine sia genuina o contraffatta: l’unica cosa che conta è se conferma o meno la nostra visione delle cose.

È esattamente ciò che è successo a Conan Doyle con la foto delle fate e ciò che aveva intuito Joseph McCarthy: l’immagine contraffatta che mostrava il suo avversario MIllard Tydings chiacchierare con un esponente del partito comunista non aveva l’obiettivo di far credere a tutti che i due fossero amici, ma solo di rafforzare i sentimenti dei suoi sostenitori e creare un’associazione mentale a lui favorevole.

Il punto allora non è che i deepfake possano, da soli, cambiare le sorti di un’elezione, ma che le persone siano travolte dalla diffidenza o, peggio ancora, nemmeno più interessate alla veridicità di un contenuto.

È semmai questo il vero problema dei deepfake (e delle classiche fake news): polarizzano ulteriormente le posizioni e fanno leva solo sull’emotività. Inoltre, aumentano la diffidenza verso tutto ciò che vediamo, fornendo la scusa perfetta per non credere a ciò a cui non vogliamo credere. Il punto allora non è che i deepfake possano, da soli, cambiare le sorti di un’elezione (il che potrebbe comunque teoricamente succedere, se sufficientemente verosimili, diffusi con il giusto tempismo e in una competizione equilibrata), ma che le persone siano travolte dalla diffidenza o, peggio ancora, nemmeno più interessate alla veridicità di un contenuto.

In tutto ciò, anche il giornalismo ha una sua responsabilità: la continua pubblicazione di “notizie che non lo erano” da parte di testate nazionali in cerca di viralità e click fa sì che, come spiega un report del Reuters Institute, una percentuale crescente di lettori condivida delle notizie divertenti e curiose soltanto “per il LOL”, senza il minimo interesse verso la loro veridicità (è il caso della notizia dello scacchista che avrebbe ingannato l’avversario usando “perline anali”, ripresa da tantissime testate e diventata virale nonostante fosse basata esclusivamente su supposizioni ad alto tasso di ironia nate su Reddit).

Visti in questa cornice, i deepfake sono solo una piccola parte di un problema molto più ampio. Che non riguarda i singoli episodi o la possibilità di manipolare una competizione elettorale con un video contraffatto, ma una tendenza più generale e di lungo termine, in cui la nebbia informativa si fa talmente fitta che ci affidiamo esclusivamente alle nostre convinzioni e per il resto preferiamo andare alla cieca: fatalisti, sfiduciati e disinteressati. Finendo inevitabilmente per schiantarci.